Как закрыть сайт от поисковых систем: robots.txt, htaccess, метатеги

Чтобы какой-либо сайт появился в выдаче поисковой системы, он должен быть предварительно проиндексирован, то есть просканирован поисковыми роботами. Следующий этап – ранжирование – определение места ресурса в выдаче. На него влияет нескольких критериев, в числе которых можно выделить релевантность – степень соответствия результатов выдачи запросу пользователя. Чтобы сайт был более релевантным, необходимо регулировать перемещения и поведение поискового робота на нем. Как правило, от поисковиков также скрывают пагинацию, фильтры, служебные и страницы, содержащие личные данные пользователей. В этой статье мы рассмотрим все известные способы, как закрыть документ от поисковых систем, и объясним, для чего может пригодиться каждый из них.

Закрытие от индексации с помощью файла Robots.txt

Самым распространенным способом указать поисковым роботам страницы, представленные или, наоборот, закрытые для посещения, является robots.txt. Это обычный текстовый файл, размещенный в корневом каталоге интернет-ресурса, в котором описаны инструкции для поисковых ботов.

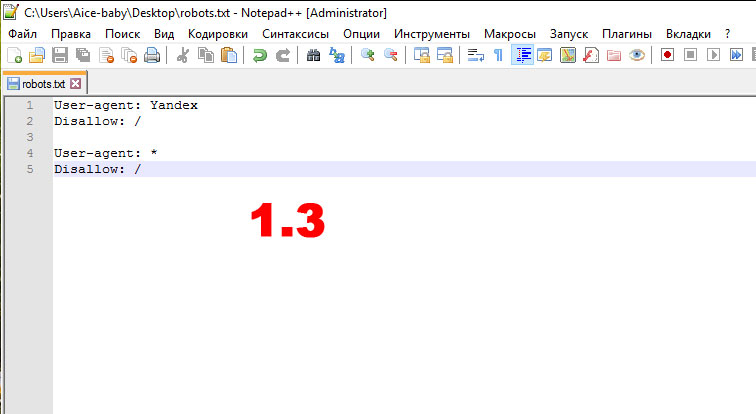

Чтобы закрывать сразу весь сайт от индексации, вам понадобится прописать в файле robots.txt всего две строчки:

В данной инструкции вы сообщаете, что она распространяется на все поисковые системы (User-agent: *); вторая строка (Disallow: /) означает, что запрет касается всех страниц сайта.

В случае необходимости закрыть ресурс только от одной поисковой системы, в строке User-agent: указываем, для какой именно. Чаще всего прописывают поисковые системы Yandex или Google:

User-agent: Yandex

Disallow: /

User-agent: GoogleBot

Disallow: /

Строка Disallow может также содержать инструкции относительно отдельных частей, разделов или папок сайта, которые нежелательны для обхода роботов.

Для запрета индексации:

User-agent: *

Disallow: файл1.htm

Disallow: файл2.htm

Disallow: файл3.htm

Следует учитывать, что robots.txt воспринимается поисковиками по-разному, и роботы Google не всегда следуют его указаниям, воспринимая содержимое файла как рекомендацию.

Закрытие от индексации с помощью метатегов

Метатег Robots прописывается внутри тега html-документа и имеет следующие значения:

Принцип работы с этими метатегами такой же, как и с файлом robots.txt. Единственное исключение – они используются непосредственно на тех страницах, которые необходимо закрыть. Если же речь идет обо всем ресурсе, данные теги прописывают прямо в шаблон сайта. Пример использования метатегов robots:

Здесь указано,что роботам запрещено индексировать страницы и обходить ссылки.

Вот еще несколько полезных тегов:

Для каждой поисковой системы – отдельная строка.

AuthType Basic

AuthUserFile /указать_путь файла_с_паролем

Require valid-user

Средства для владельцев сайтов на WordPress

Если вам посчастливилось быть обладателем ресурса на WordPress, то вы можете закрыть свой сайт от индексации с помощью самой админки, совершив лишь несколько кликов мышью:

Также существует ряд SEO-плагинов, например, «All in One SEO Pack», с помощью которых можно контролировать индексацию отдельных документов сайта.

Другие CMS также могут включать в себя подобные функции и плагины.

Какой бы вы ни выбрали способ закрытия от индексации, помните: самое надежное средство от попадания в индекс – хранить сайт на сервере, отключенном от всемирной сети.

Практические решения закрытия сайта или его части от индексации

Зачем закрывают сайт или какие-то его части от индексации поисковых систем? Ответов несколько

Вся статья будет неким хелпом по закрытию от индексации для различных ситуаций:

Решение: запрет на индексацию сайта с помощью robots.txt

Создаем текстовый файл с названием robots, получаем robots.txt.

Копируем туда этот код

Полученный файл с помощью FTP заливаем в корень сайта.

Если нужно закрыть индексацию сайта только от Яндекс:

Если же скрываем сайт только от Google, то код такой:

Способ первый

Каждая строчка для отдельной поисковой системы

Способ второй и третий

Способ четвертый

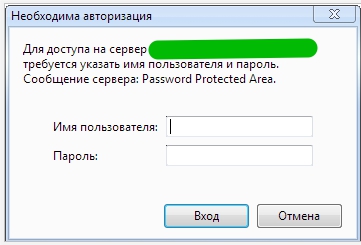

Запретить индексацию с помощью доступа к сайту только по паролю

Авторизацию уже увидите, но она пока еще не работает

Теперь необходимо добавить пользователя в файл паролей:

USERNAME это имя пользователя для авторизации. Укажите свой вариант.

Задача: закрыть от индексации поддомен

Поддомен для поисковых систем является отдельным сайтом, из чего следует, что для него подходят все варианты того, как закрыть от индексации сайт.

Закрываем блок на сайте от индекса

Довольно часто требуется закрыть от индексации определенный блок: меню, счетчик, текст или какой-нибудь код.

Когда был популярен в основном Яндекс, а Google все само как то в топ выходило, все использовали вариант Тег «noindex»

Как это реализовать?

BASE64.js. Здесь я его приводить не буду, в данном контексте он нам не так интересен.

Переменные seoContent и seoHrefs. В одну записываем html код, в другую ссылки.

В robots.txt обязательно скрываем от индексации файл SEOhide.js.

Универсальный вариант скрытия картинок от индексации

К примеру, вы используете на сайте картинки, но они не являются оригинальными. Есть страх, что поисковые системы воспримут их негативно.

Код элемента, в данном случае ссылки, на странице, будет такой:

Скрипт, который будет обрабатывать элемент:

Задача: закрыть внешние или внутренние ссылки от индексации

Обычно это делают для того, чтобы не передавать вес другим сайтам или при перелинковке уменьшить уходящий вес текущей страницы.

Создаем файл transfers.js

Эту часть кода вставляем в transfers.js

Этот файл, размещаем в соответствующей папке (как в примере «js») и на странице в head вставляем код:

А это и есть сама ссылка, которую нужно скрыть от индексации:

Как закрыть от индексации страницу на сайте

это серый метод, использовать в крайних мерах

Как закрыть от индексации сразу весь раздел на проекте

1 Вариант реализовать это с помощь robots.txt

Конечно же проще всего это прописать запрет в robots, но наша практика показывает, что это не 100% вариант и поисковые системы бывает игнорируют запреты.

Закрываем папку от индексации

Единственный вариант для отдельной папки это реализация через robots.txt

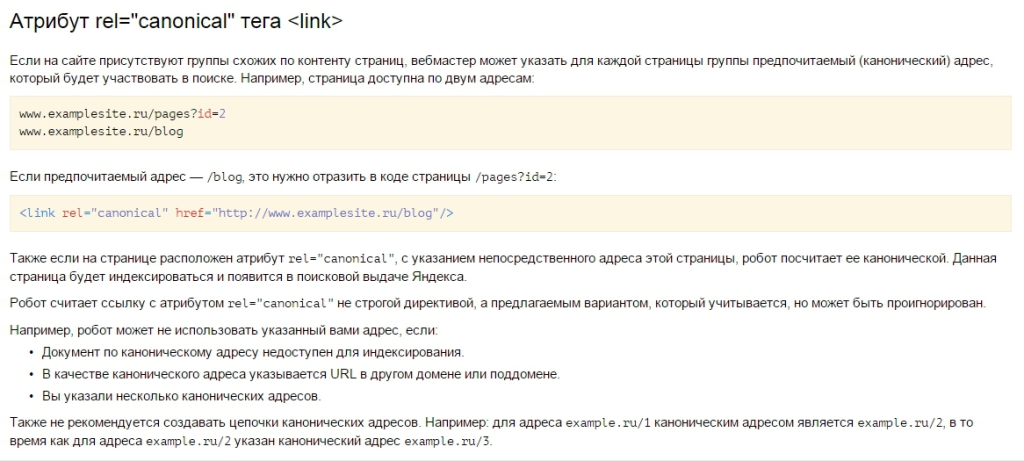

Пять вариантов закрыть дубли на сайте от индексации Яндекс и Google

Ну странице дубля к коде необходимо указать

Если что то упустили, будем рады любым дополнениям в комментариях.

Запрет индексации, robots и htaccess. Закрыть от индексации страницы, папки, поддомены, ссылки.

Запрет индексации, robots и htaccess. Закрыть от индексации страницы, папки, поддомены, ссылки.

Читайте так же — запрет индексации:

Запрет индексации требуется в том случае, когда вы не хотите, чтобы ваша информация попала в результаты поисковой выдачи. Так же это бывает необходимо, если вы не хотите, чтобы страницы не передавали свой вес другим, на которые стоят ссылки. На самом деле, задачи запрета индексации страниц и ссылок имеют одинаковые верные решения. То есть, если вы хотите скрыть от роботов страницу, недостаточно скрыть ссылку на нее. Тем более недостаточно запретить индексацию в robots.txt, ведь роботы прекрасно проходят на такие страницы по внешним ссылкам с других сайтов.

Запрет индексации требуется в том случае, когда вы не хотите, чтобы ваша информация попала в результаты поисковой выдачи. Так же это бывает необходимо, если вы не хотите, чтобы страницы не передавали свой вес другим, на которые стоят ссылки. На самом деле, задачи запрета индексации страниц и ссылок имеют одинаковые верные решения. То есть, если вы хотите скрыть от роботов страницу, недостаточно скрыть ссылку на нее. Тем более недостаточно запретить индексацию в robots.txt, ведь роботы прекрасно проходят на такие страницы по внешним ссылкам с других сайтов.

А потом, к тому же, берут из общедоступных источников(например dmoz.org) тайтл, который может быть уже неактуален. Таким образом, страница попадает в выдачу. Атрибут rel = nofollow всего лишь не дает ссылке передать вес странице акцептору, но отнимает у донора. А, в случае внутренней перелинковки, может серьезно нарушить процесс распределения весов. В итоге, единственным эффективным методом является запрет индексации в htaccess, который описан ниже. Подобные рассуждения ведет Мэтт Каттс (Matt Cutts) руководитель Google’s Webspam team в небольшом видео-уроке.>>>

Если доступа к robots.txt нет, стоит использовать метатег noindex. Именно метатег.

Тег noindex иногда используют с целью оптимизации сниппетов, но в остальном пользы от него не замечено. Взамен объяснений дам ссылку на статью —

Запрет индексации ссылки в htaccess:

Для этого можно создать скриптик:

назвать его redirect.php и сохранить в папке http://mysite.ru/outlink/

Скрипту передавать параметр url:

Первый вариант – доступ к http://mysite.ru/outlink/ запретить роботам, как описано выше.

В htaccess задать страницу 403 ошибки или возвращать ее на главную:

ErrorDocument 403 http://mysite.ru/

Таким образом все будут переходить по адресу, заданному параметром url, но поисковые роботы будут попадать на главную, предварительно получив ответ:

302 Moved Permanently, Location: http://mysite.ru/;

Второй вариант – это в /outlink/.htaccess :

RewriteRule ^(.*)$ http://mysite.ru/? [L,R=301]

В этом случае робот получит ответ:

301 Moved Permanently, Location: http://mysite.ru/;

Третий вариант – в http://mysite.ru/outlink/.htaccess :

(кстати рекомендованный Мэттом Каттсом

AuthType Basic

AuthName ‘BBEguTE 1 u 1′ //сообщение только на латинице

AuthUserFile /’путь от корня сервера’/outlink/.htpasswd

Require valid-user

//лишний пробел после //лишний пробел после

Из переменной DOCUMENT_ROOT => /home/www/users/AM/public_html берем путь и ставим вместо ‘путь от корня сервера’.

Проверить работу этих и других методов запрета индексации можно зайдя на сайт с помощью этой формочки посмотреть как поисковый робот.

Закрыть сайт от индексации

Пошаговая инструкция как закрыть сайт на wordpress (и другие) от индексации.

Приятного чтения!

Заказывайте у нас настройку и сопровождение контекстной рекламы, а также создание сайтов.

Есть несколько вариантов:

I. Через файл robots.txt;

II. Через файл .htaccess;

III. Через метатеги noindex, nofollow;

IV. Через панель администратора wordpress;

Закрываем индексацию сайта через файл robots.txt:

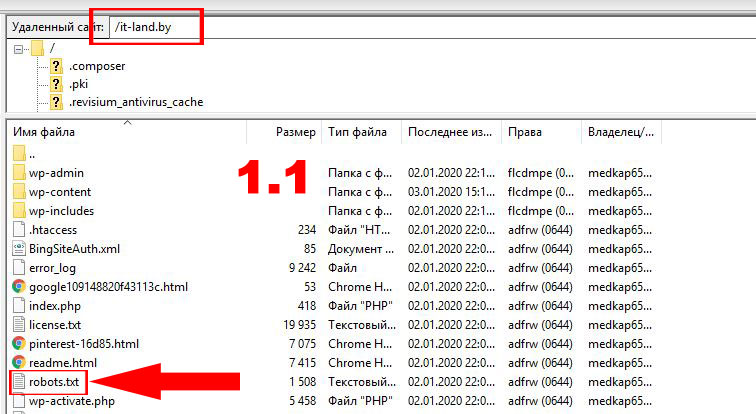

1.1 Для начала проверим есть ли такой файл. Для этого зайдем на сервере в папку с файлами сайта, обычна она называется также как доменное имя:

1.2 Если такого файла нет:

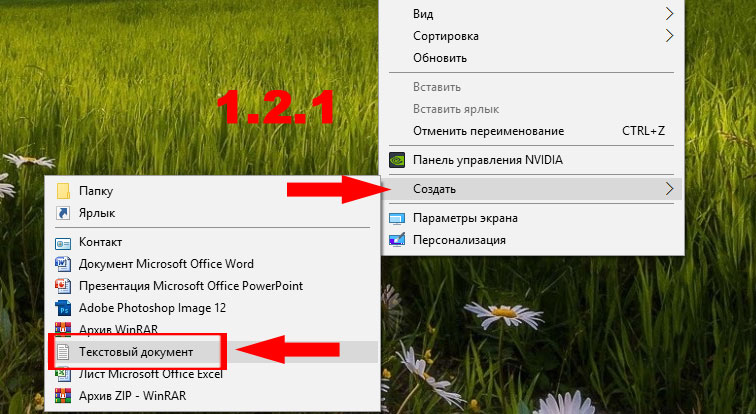

1.2.1 На рабочем столе компьютера нажимаем правой кнопкой мыши, в выпавшем меню выбираем “Создать”, далее выбираем “Текстовый документ”:

1.2.2 Новому файлу даем имя robots

Внимание! Не пишите “robots.txt”, так как будет двойное расширение robots.txt.txt

1.3 Если же на сервере такой файл был, то скачиваем его к себе на ПК;

1.4 Открываем файл robots.tx в любом текстовом редакторе и пишем:

1.4 Загружаем на сервер;

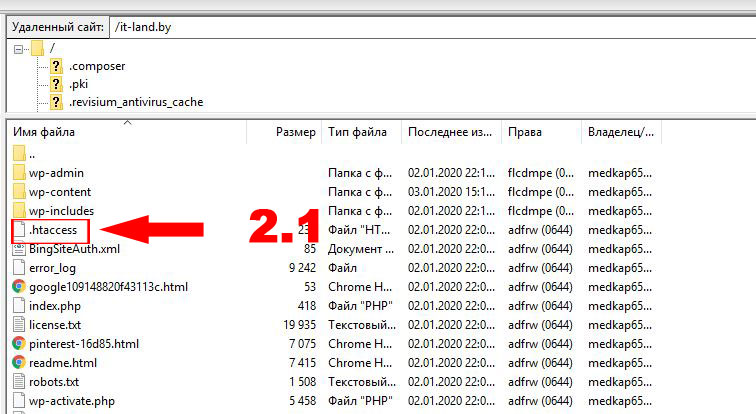

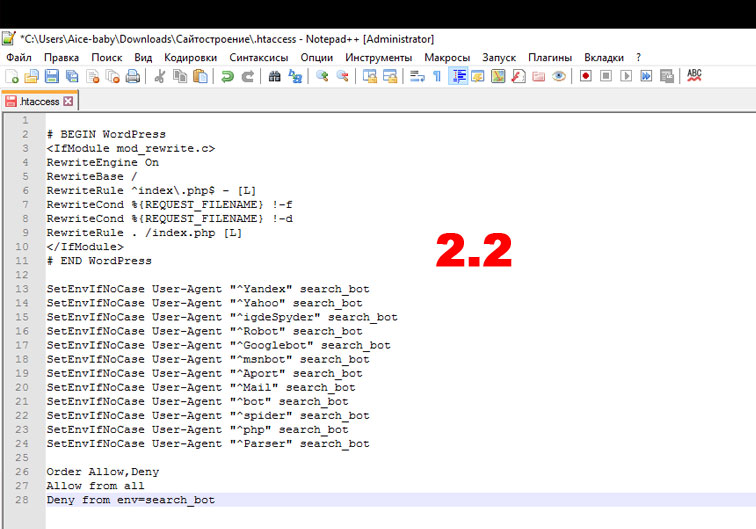

2.1 Файл находится в корневой папке сайта, откуда его скачиваем к себе:

2.2 Скачиваем его к себе на компьютер и открываем в любом текстовом редакторе, после чего добавляем:

Так как у меня сайт на CMS WordPress, то мой файл будет выглядеть вот так:

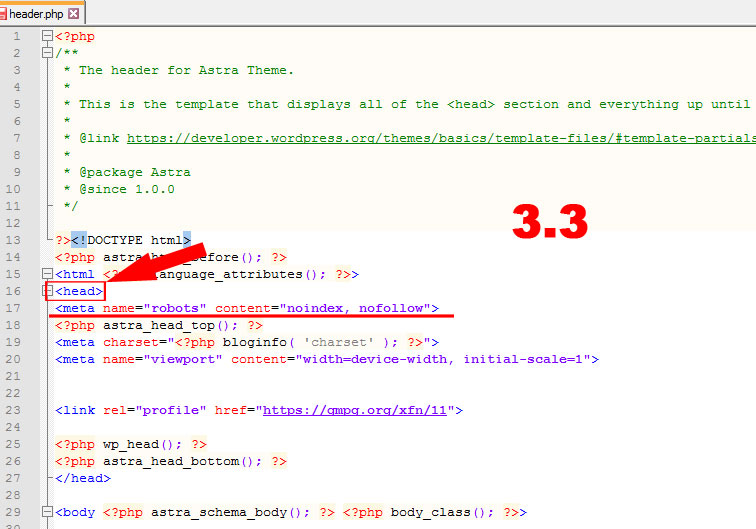

Запрещаем индексацию через метатеги noindex, nofollow

Для этого нужно знать, в каком из файлов лежит шаблон header для страниц вашего сайта. Ниже я опишу вариант для WordPress

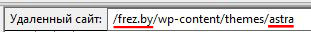

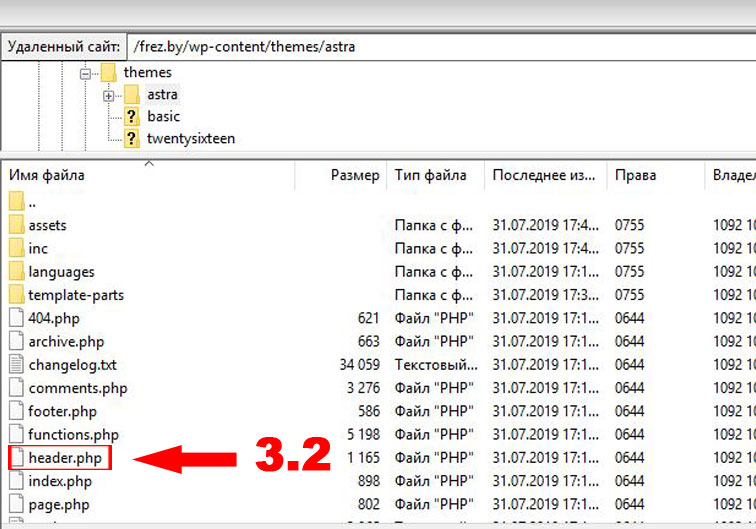

3.1 Для вордпресса вы должны зайти на сервере по директории /ДОМЕННОЕ ИМЯ ВАШЕГО САЙТА/wp-content/themes/ВАША ТЕМА. Ниже приведен пример для сайта frez.by с используемой темой astra:

3.2 Находим файл “header.php”:

3.3 Скачиваем это файл себе на компьютер с сервера и открываем в текстовом редакторе. После чего находим тег “ ”, после которого сразу вставляет метагег:

3.4 Сохраняем файл и не забываем закачать обратно на сервер;

Как закрыть сайт от индексации wordpress через панель управления

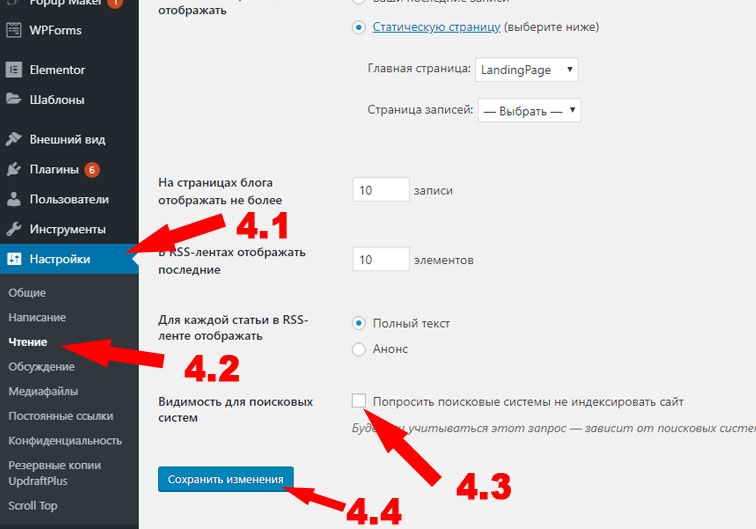

4.1 Заходим в административную панель сайта, в боков меню ищем раздел “Настроки” (4.1), далее выбираем подраздел “Чтение” (4.2), далее в низу страницы находим предложение “Попросить поисковые системы не индексировать сайт” и ставим галочку (4.3) и не забываем сохранить (4.4):

Теперь вы знаете как закрыть сайт от индексации.

Надеюсь статья была вам полезна.

Если есть вопросы – задавайте в комментариях

Закажите создание сайта, или продвижение, или контекстную рекламу у нас

Подпишитесь на новые статьи или новости сайта It-land.by

Похожие записи:

Woocommerce: изменить цены

Доступ к гугл аналитикс

Как можно менять геозону поисковой выдачи

Расширения браузера Google Chrome для Seo-анализа сайтов

Добавить комментарий Отменить ответ

Этот сайт использует Akismet для борьбы со спамом. Узнайте, как обрабатываются ваши данные комментариев.

Htaccess запретить индексацию сайта

Войти

Авторизуясь в LiveJournal с помощью стороннего сервиса вы принимаете условия Пользовательского соглашения LiveJournal

Главной особенностью было то, что запрет на индексацию нужно было сделать не через прописывание запрета в robots.txt, а с помощью файла .htaccess.

Нужно это было для того, чтобы никто кроме меня не знал, что я запретил.

Для осуществления данного действия нужно чтобы у вас в корневой папке домена находился файл .htaccess.

Кстати в проводнике windows с этим могут быть проблемы.

Когда вы убедились, что файлик .htaccess есть, в него просто нужно дописать следующие строки:

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase User-Agent «^Yandex» search_bot

SetEnvIfNoCase User-Agent «^Yahoo» search_bot

Вышеописанные строки для трех основных поисковиков Google, Yandex и Yahoo.

Попробую расшифровать написанное на примере Google

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase – это мы задаем условия для переменной env

User-Agent – означает какая именно переменная, в данном случае это имя агента или бота поисковой машины

«^Googlebot» собственно это имя этого агента

А search_bot – это значение переменной

Другими словами (по русски) строчка

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

Значит: если на сайт придет бот у которого в имени будет содержаться слово Googlebot, то такому боту задать значение переменной env= search_bot (пометить его как search_bot)

Вот список других ботов которые могут вас навестить:

SetEnvIfNoCase User-Agent «^Aport» search_bot

SetEnvIfNoCase User-Agent «^msnbot» search_bot

SetEnvIfNoCase User-Agent «^spider» search_bot

SetEnvIfNoCase User-Agent «^Robot» search_bot

SetEnvIfNoCase User-Agent «^php» search_bot

SetEnvIfNoCase User-Agent «^Mail» search_bot

SetEnvIfNoCase User-Agent «^bot» search_bot

SetEnvIfNoCase User-Agent «^igdeSpyder» search_bot

SetEnvIfNoCase User-Agent «^Snapbot» search_bot

SetEnvIfNoCase User-Agent «^WordPress» search_bot

SetEnvIfNoCase User-Agent «^BlogPulseLive» search_bot

SetEnvIfNoCase User-Agent «^Parser» search_bot

Deny from env=search_bot

в строке Order Allow,Deny

Мы указываем порядок доступа, у нас сказано сначала разрешить, а потом запретить

Allow from all – разрешить всем

Deny from env=search_bot – запретить доступ тем, кто помечен флажком search_bot, в данном случае это боты, которые мы перечисляли выше

Deny from env=search_bot

То есть все тоже самое, но мы ограничиваем область запрета в FilesMatch

-тут мы запрещаем доступ только к файлу primer.html

— запрет к любому файлу, содержащему слово primer

Запрет на любой файл для ботов:

SetEnvIfNoCase User-Agent «^Yandex» search_bot

SetEnvIfNoCase User-Agent «^Yahoo» search_bot

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase User-Agent «^Aport» search_bot

SetEnvIfNoCase User-Agent «^msnbot» search_bot

SetEnvIfNoCase User-Agent «^spider» search_bot

SetEnvIfNoCase User-Agent «^Robot» search_bot

SetEnvIfNoCase User-Agent «^php» search_bot

SetEnvIfNoCase User-Agent «^Mail» search_bot

SetEnvIfNoCase User-Agent «^bot» search_bot

SetEnvIfNoCase User-Agent «^igdeSpyder» search_bot

SetEnvIfNoCase User-Agent «^Snapbot» search_bot

SetEnvIfNoCase User-Agent «^WordPress» search_bot

SetEnvIfNoCase User-Agent «^BlogPulseLive» search_bot

SetEnvIfNoCase User-Agent «^Parser» search_bot

Deny from env=search_bot

Запрет на файл primer.html для трех основных поисковиков Google, Yandex и Yahoo

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase User-Agent «^Yandex» search_bot

SetEnvIfNoCase User-Agent «^Yahoo» search_bot

Deny from env=search_bot

Кстати точно также можно запретить и доступ с определенного ip.

Для этого нужно записать

SetEnvIfNoCase Remote_Addr 123\.123\.123\.123 search_bot