Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

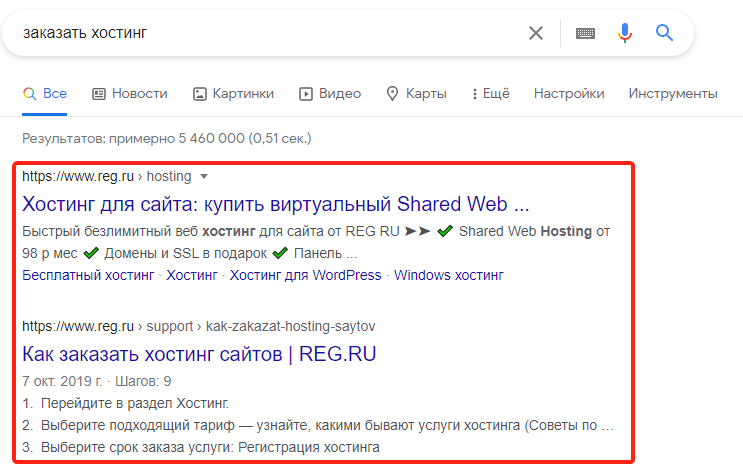

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

Добавьте в начало нужные строки.

Руководство: как закрыть сайт от индексации в поисковых системах? Работа с файлом robots.txt

На стадии разработки и/или редизайна проекта бывают ситуации, когда лучше не допускать поисковых роботов на сайт или его копию. В этом случае рекомендуется закрыть сайт от индексации поисковых систем. Сделать это можно следующим образом:

Закрыть сайт от индексации очень просто, достаточно создать в корне сайта текстовый файл robots.txt и прописать в нём следующие строки:

User-agent: Yandex

Disallow: /

Такие строки закроют сайт от поискового робота Яндекса.

А таким образом можно закрыть сайт от всех поисковых систем (Яндекса, Google и других).

Как закрыть от индексации отдельную папку? #

Отдельную папку можно закрыть от поисковых систем в том же файле robots.txt с её явным указанием (будут скрыты все файлы внутри этой папки).

User-agent: *

Disallow: /folder/

Если какой-то отдельный файл в закрытой папке хочется отдельно разрешить к индексации, то используйте два правила Allow и Disallow совместно:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Как закрыть отдельный файл в Яндексе? #

User-agent: Yandex

Disallow: /folder/file.php

Как проверить, в индексе документ или нет? #

Проще всего осуществить проверку в рамках сервиса «Пиксель Тулс», бесплатный инструмент «Определение возраста документа в Яндексе» позволяет ввести URL списком. Если документ отсутствует в индексе, то в таблице будет выведено соответствующее значение.

Анализ проведён с помощью инструментов в сервисе Пиксель Тулс.

Как скрыть от индексации картинки? #

Картинки форматов jpg, png и gif могут быть запрещены к индексации следующими строчками в robots.txt:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Как закрыть поддомен? #

У каждого поддомена на сайте, в общем случае, имеется свой файл robots.txt. Обычно он располагается в папке, которая является корневой для поддомена. Требуется скорректировать содержимое файла с указанием закрываемых разделов с использованием директории Disallow. Если файл отсутствует — его требуется создать.

При использовании CDN-версии #

Как обращаться к другим поисковым роботам (список) #

У каждой поисковой системы есть свой список поисковых роботов (их несколько), к которым можно обращаться по имени в файле robots.txt. Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

Прочие директивы в robots.txt #

Поисковая система Яндекс также поддерживает следующие дополнительные директивы в файле:

«Crawl-delay:» — задает минимальный период времени в секундах для последовательного скачивания двух файлов с сервера. Также поддерживается и большинством других поисковых систем. Пример записи: Crawl-delay: 0.5

«Clean-param:» — указывает GET-параметры, которые не влияют на отображение контента сайта (скажем UTM-метки или ref-ссылки). Пример записи: Clean-param: utm /catalog/books.php

«Sitemap:» — указывает путь к XML-карте сайта, при этом, карт может быть несколько. Также директива поддерживается большинством поисковых систем (в том числе Google). Пример записи: Sitemap: https://pixelplus.ru/sitemap.xml

Закрыть страницу и сайт с помощью meta-тега name=»robots» #

Также, можно закрыть сайт или заданную страницу от индексации с помощь мета-тега robots. Данный способ является даже предпочтительным и с большим приоритетом выполняется пауками поисковых систем. Для скрытия от индексации внутри зоны документа устанавливается следующий код:

Или (полная альтернатива):

С помощью meta-тега можно обращаться и к одному из роботов, используя вместо name=»robots» имя робота, а именно:

Для паука Google:

Или для Яндекса:

Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

Добавьте в начало нужные строки.

Robots.txt и запрет индексации всего сайта

Хотите узнать, как запретить индексацию сайта в robots.txt и с помощью других инструментов? Тогда представленный материал – именно для вас.

Безусловно, владельцы сайтов борются за то, чтобы их ресурс как можно быстрее проиндексировался поисковыми системами. Но бывают случаи, когда необходимо, чтобы поисковый бот на какое-то время не посещал ресурс и не добавлял в свой индекс материалы с вашего web ресурса. Такими случаями могут быть:

Можно закрыть весь сайт целиком или же его отдельные части:

Есть много способов, с помощью которых можно закрыть сайт от индексации. Редактирование файла robots.txt – один из них. Мы рассмотрим этот способ и еще два наиболее популярных и простых.

Как закрыть сайт от индексации для Яндекса, Google и всех поисковых систем в robots.txt

Редактирование файла robots.txt – один из самых надежных и быстрых способов установить этот запрет для поисковых системам на какое-то время или же навсегда. Что для этого нужно сделать:

Запрет индексации в robots.txt сайта можно устанавливать как для конкретных поисковых систем, так и всех поисковиков. Мы рассмотрим разные варианты.

Чтобы закрыть сайт от индексации поисковыми ботами Google, потребуется в файле robots.txt написать следующее:

Для того, чтобы проверить, закрылся ли сайт от индексации, создается аккаунт и добавляется нужный домен в Google Webmaster. Здесь предусмотрена функция проверки.

После этого будут показаны результаты. Если сайт запрещен для индексации, то будет написано «Заблокировано по строке» и указано, какая строка блокирует индексацию. Если же какие-то действия по запрету индексации поисковыми ботами Google были выполнены некорректно, то будет подписано «Разрешено».

Следует учесть, что невозможно с помощью robots.txt поисковой системе Google на 100% запретить индексацию. Это своего рода рекомендация для Гугла, так как он сам решит, выполнять ли ему индексацию отдельного документа, или нет.

Чтобы закрыть материалы сайта от индексации Яндексом, в файле robots.txt нужно ввести следующее:

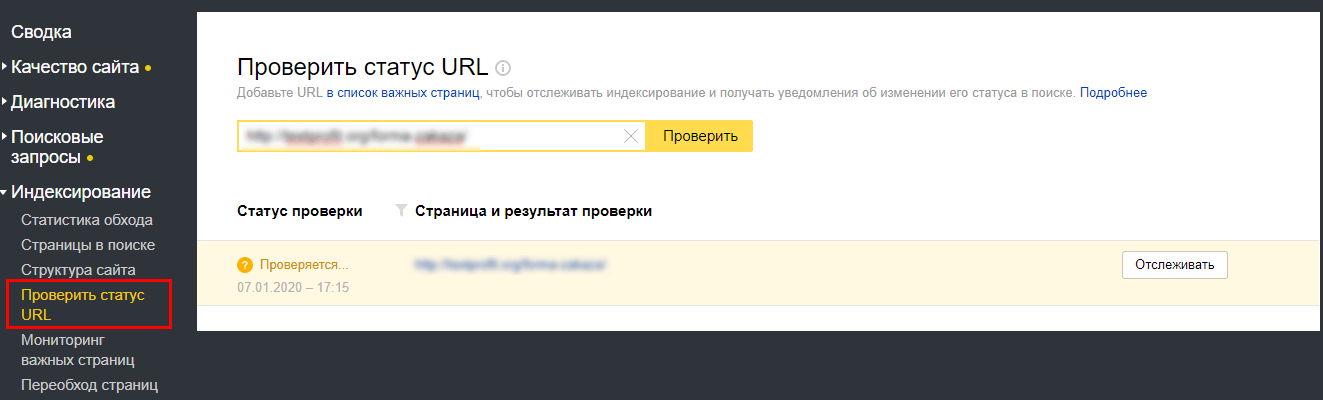

Для проверки статуса ресурса его нужно добавить в Яндекс Вебмастер, где затем нужно ввести несколько страниц со своего сайта и нажать кнопку «Проверить». Если все получилось, в строке будет высвечиваться надпись «Запрещен правилом».

Можно также установить запрет на индексацию вашего сайта одновременно для всех поисковых систем. Для этого, опять же, открываем файл robots.txt и прописываем в нем такую строку:

Проверка запрета индексации для Гугла и Яндекса выполняется по вышеописанной схеме в Google Webmaster и Яндекс Вебмастер соответственно.

Чтобы увидеть свой файл robots.txt, нужно перейти по адресу Вашдомен.ru/robots.txt. Здесь будет отображаться все, что было прописано. Бывает так, что появляется ошибка 404. Это говорит о том, что было выполнено что-то не так при загрузке своего файла.

Запрет индексации ресурса при помощи панели инструментов

Способ закрытия сайта от индексации с помощью панели инструментов подойдет только для тех ресурсов, которые были сделаны на Вордпресс.

Порядок действий простой и быстрый:

Выполнение данных действий – всего лишь рекомендация для поисковых машин. А то, будут ли индексироваться или не индексироваться материалы ресурса, они решают самостоятельно. В настройках видимости сайта даже присутствует специальная строка: «Поисковые машины сами решают, следовать ли Вашей просьбе». Отметим, что Яндекс обычно «слушается», а Гугл может поступать по своему усмотрению и все равно в некоторых случаях индексировать сайт, несмотря на рекомендацию.

Закрытие сайта от индексации вручную

В исходном коде при закрытии страницы или всего ресурса от индексации появляется строка

Именно эта строка подсказывает поисковым машинам, что не нужно индексировать отдельные материалы или ресурс. Можно вручную в любом месте сайта прописать данную строчку. Главное, чтобы она отображалась на всех страницах.

Этот способ подойдет также для того, чтобы закрыть какой-либо ненужный документ от индексации.

После выполнения обновлений нужно проверить, все ли получилось. Для этого нужно открыть исходный код с помощью клавиш CTRL + U и посмотреть, есть ли в нем нужная строчка. Ее наличие подтверждает успешную операцию по закрытию от индексации. Дополнительно можно осуществить проверку в Яндекс Вебмастер и Google Webmaster.

Итак, мы рассмотрели самые простые и быстрые способы, позволяющие закрыть весь сайт или отдельные материалы ресурса от индексации поисковыми машинами. И, как выяснилось, robots.txt – один из легких и относительно надежных способов.

Проверка индексации сайта онлайн

Методы ускорения индексации сайта в яндексе

Директивы в файле robots.txt

Как использовать robots.txt и кеш Гугла

Быстрая индексация сайта в Гугле

Seo – проверка индексации текста и веса ссылок тест

Как закрыть сайт от индексации

Поделиться этим постом

Закрывать сайт от индексации нужно, например, при проведении технических работ. Это можно сделать несколькими способами: через robots.txt, метатег robots или заголовок X-Robots-Tag. Вебмастера иногда сталкиваются с ситуацией, когда запрет не срабатывает, и страницы сайта все равно индексируются поисковиками. В посте расскажем о том, как запретить индексацию сайта и убедиться в корректности этого запрета.

1. Зачем закрывать сайт или страницу от индексации

После релиза сайта его страницы сканируются роботами при первом обходе. Однако если дизайн и контент страниц пока ещё не оптимизированы для продвижения, рекомендуется на время доработок закрыть сайт от поисковиков. В каких ещё ситуациях нужен запрет на индексацию:

Запрет на сканирование — часто временное явление. После окончания технических работ вы сможете вернуть сайт в прежнее состояние. Такой шаг помогает сохранить позиции в выдаче.

2. Как закрыть сайт от индексации

Я уже упомянула, что полностью запретить индексацию сайта можно тремя способами. Теперь предлагаю рассмотреть каждый из них отдельно.

2.1. Robots.txt

Файл robots.txt позволяет запретить индексацию страниц, разделов или всего сайта. Используйте директиву Disallow в качестве команды для поисковых роботов. Если нужно закрыть весь сайт от всех роботов, пропишите в файле robots.txt:

Для обращения к конкретному роботу вместо «*» используйте его название. Например, если нужно закрыть сайт от Яндекс, впишите в robots.txt:

Если требуется закрыть от индексации всеми роботами определённые разделы, укажите их после директивы Disallow. Для каждого типа контента используйте отдельную директиву. Пример:

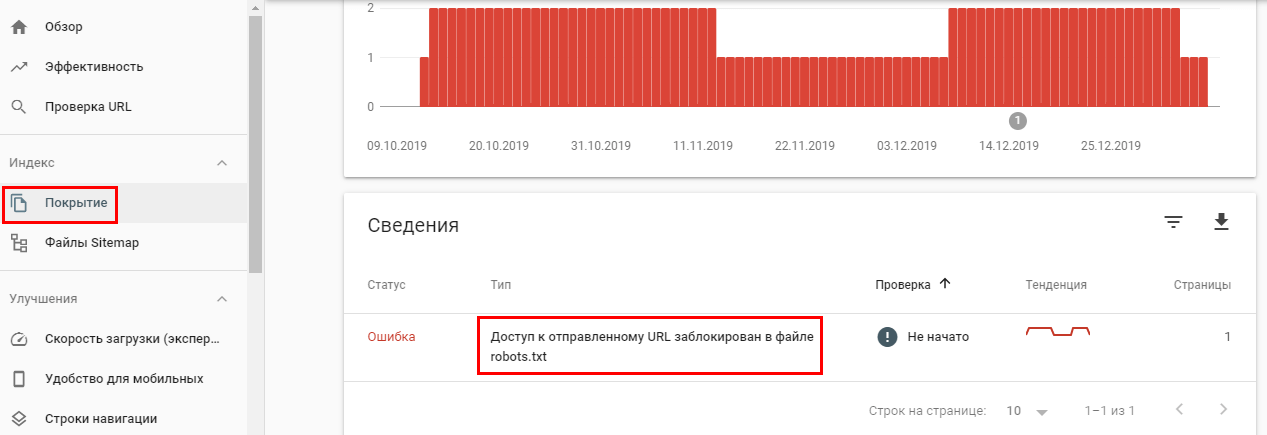

Многие SEO-оптимизаторы отмечают, что Google часто игнорирует директиву Disallow и продолжает индексировать все страницы сайта. Проверить это можно в Google Search Console.

Если страница закрыта от индекса в robots.txt, но это не указано в панели вебмастеров, скорее всего, Google-бот продолжит индексировать эту страницу.

Для проверки в Яндекс.Вебмастер перейдите в раздел «Индексирование».

Если директива Disallow в robots.txt не помогает закрыть страницу от индексации, используйте следующий метод.

2.2. Метатег Robots

Этим способом можно предотвратить сканирование роботами контента. С его помощью можно также закрыть текст от индексации. Это необходимо, когда страницу нужно проиндексировать за исключением отрывка текста. Для этого добавьте в раздел страницы строку кода:

Чтобы скрыть ссылку от поисковиков, используйте nofollow:

Если и этот вариант не помогает, используйте метод серверного заголовка, описанный в следующем пункте.

2.3. X-Robots-Tag

С помощью X-Robots-Tag можно закрыть от индексации медиа-контент, скрипты и другие файлы. Для этого нужно указать их формат после директивы FilesMatch в первой строке заголовка.

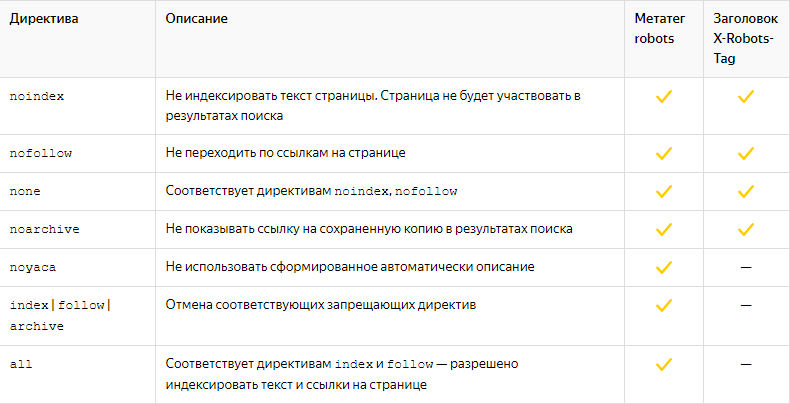

Большинство директив, которые можно использовать в X-Robots-Tag, совпадают с директивами Robots.

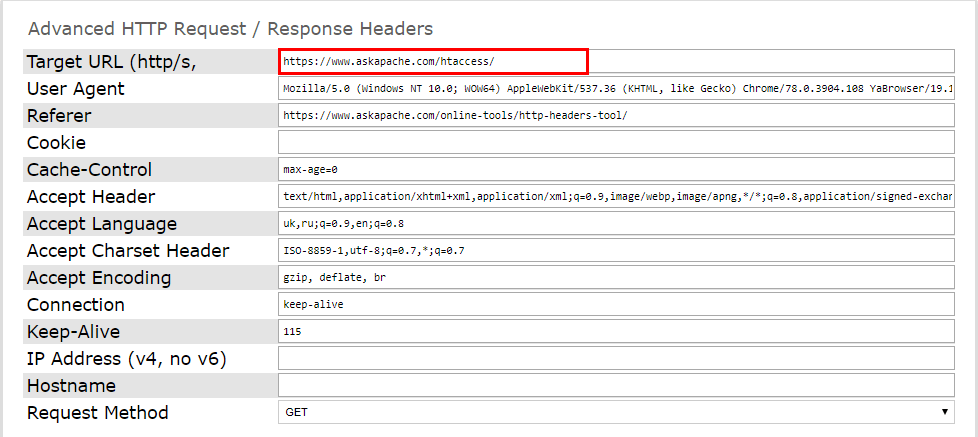

И проверьте работоспособность серверного заголовка. Это можно сделать при помощи онлайн-инструментов. Например, Askapache. Введите нужную страницу и запустите проверку.

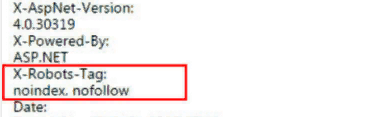

Подключённый заголовок выглядит так:

Проверить код ответа сервера можно и через Яндекс.Вебмастер. Активный X-Robots-Tag отобразится в списке всех заголовков ответа сервера.