Руководство: как закрыть сайт от индексации в поисковых системах? Работа с файлом robots.txt

На стадии разработки и/или редизайна проекта бывают ситуации, когда лучше не допускать поисковых роботов на сайт или его копию. В этом случае рекомендуется закрыть сайт от индексации поисковых систем. Сделать это можно следующим образом:

Закрыть сайт от индексации очень просто, достаточно создать в корне сайта текстовый файл robots.txt и прописать в нём следующие строки:

User-agent: Yandex

Disallow: /

Такие строки закроют сайт от поискового робота Яндекса.

А таким образом можно закрыть сайт от всех поисковых систем (Яндекса, Google и других).

Как закрыть от индексации отдельную папку? #

Отдельную папку можно закрыть от поисковых систем в том же файле robots.txt с её явным указанием (будут скрыты все файлы внутри этой папки).

User-agent: *

Disallow: /folder/

Если какой-то отдельный файл в закрытой папке хочется отдельно разрешить к индексации, то используйте два правила Allow и Disallow совместно:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Как закрыть отдельный файл в Яндексе? #

User-agent: Yandex

Disallow: /folder/file.php

Как проверить, в индексе документ или нет? #

Проще всего осуществить проверку в рамках сервиса «Пиксель Тулс», бесплатный инструмент «Определение возраста документа в Яндексе» позволяет ввести URL списком. Если документ отсутствует в индексе, то в таблице будет выведено соответствующее значение.

Анализ проведён с помощью инструментов в сервисе Пиксель Тулс.

Как скрыть от индексации картинки? #

Картинки форматов jpg, png и gif могут быть запрещены к индексации следующими строчками в robots.txt:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Как закрыть поддомен? #

У каждого поддомена на сайте, в общем случае, имеется свой файл robots.txt. Обычно он располагается в папке, которая является корневой для поддомена. Требуется скорректировать содержимое файла с указанием закрываемых разделов с использованием директории Disallow. Если файл отсутствует — его требуется создать.

При использовании CDN-версии #

Как обращаться к другим поисковым роботам (список) #

У каждой поисковой системы есть свой список поисковых роботов (их несколько), к которым можно обращаться по имени в файле robots.txt. Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

Прочие директивы в robots.txt #

Поисковая система Яндекс также поддерживает следующие дополнительные директивы в файле:

«Crawl-delay:» — задает минимальный период времени в секундах для последовательного скачивания двух файлов с сервера. Также поддерживается и большинством других поисковых систем. Пример записи: Crawl-delay: 0.5

«Clean-param:» — указывает GET-параметры, которые не влияют на отображение контента сайта (скажем UTM-метки или ref-ссылки). Пример записи: Clean-param: utm /catalog/books.php

«Sitemap:» — указывает путь к XML-карте сайта, при этом, карт может быть несколько. Также директива поддерживается большинством поисковых систем (в том числе Google). Пример записи: Sitemap: https://pixelplus.ru/sitemap.xml

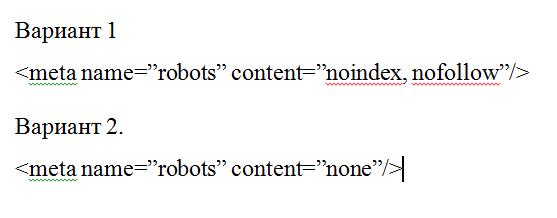

Закрыть страницу и сайт с помощью meta-тега name=»robots» #

Также, можно закрыть сайт или заданную страницу от индексации с помощь мета-тега robots. Данный способ является даже предпочтительным и с большим приоритетом выполняется пауками поисковых систем. Для скрытия от индексации внутри зоны документа устанавливается следующий код:

Или (полная альтернатива):

С помощью meta-тега можно обращаться и к одному из роботов, используя вместо name=»robots» имя робота, а именно:

Для паука Google:

Или для Яндекса:

Robots.txt и запрет индексации всего сайта

Хотите узнать, как запретить индексацию сайта в robots.txt и с помощью других инструментов? Тогда представленный материал – именно для вас.

Безусловно, владельцы сайтов борются за то, чтобы их ресурс как можно быстрее проиндексировался поисковыми системами. Но бывают случаи, когда необходимо, чтобы поисковый бот на какое-то время не посещал ресурс и не добавлял в свой индекс материалы с вашего web ресурса. Такими случаями могут быть:

Можно закрыть весь сайт целиком или же его отдельные части:

Есть много способов, с помощью которых можно закрыть сайт от индексации. Редактирование файла robots.txt – один из них. Мы рассмотрим этот способ и еще два наиболее популярных и простых.

Как закрыть сайт от индексации для Яндекса, Google и всех поисковых систем в robots.txt

Редактирование файла robots.txt – один из самых надежных и быстрых способов установить этот запрет для поисковых системам на какое-то время или же навсегда. Что для этого нужно сделать:

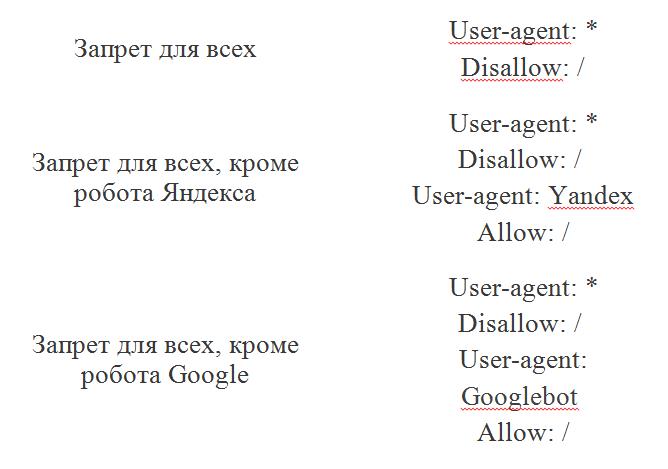

Запрет индексации в robots.txt сайта можно устанавливать как для конкретных поисковых систем, так и всех поисковиков. Мы рассмотрим разные варианты.

Чтобы закрыть сайт от индексации поисковыми ботами Google, потребуется в файле robots.txt написать следующее:

Для того, чтобы проверить, закрылся ли сайт от индексации, создается аккаунт и добавляется нужный домен в Google Webmaster. Здесь предусмотрена функция проверки.

После этого будут показаны результаты. Если сайт запрещен для индексации, то будет написано «Заблокировано по строке» и указано, какая строка блокирует индексацию. Если же какие-то действия по запрету индексации поисковыми ботами Google были выполнены некорректно, то будет подписано «Разрешено».

Следует учесть, что невозможно с помощью robots.txt поисковой системе Google на 100% запретить индексацию. Это своего рода рекомендация для Гугла, так как он сам решит, выполнять ли ему индексацию отдельного документа, или нет.

Чтобы закрыть материалы сайта от индексации Яндексом, в файле robots.txt нужно ввести следующее:

Для проверки статуса ресурса его нужно добавить в Яндекс Вебмастер, где затем нужно ввести несколько страниц со своего сайта и нажать кнопку «Проверить». Если все получилось, в строке будет высвечиваться надпись «Запрещен правилом».

Можно также установить запрет на индексацию вашего сайта одновременно для всех поисковых систем. Для этого, опять же, открываем файл robots.txt и прописываем в нем такую строку:

Проверка запрета индексации для Гугла и Яндекса выполняется по вышеописанной схеме в Google Webmaster и Яндекс Вебмастер соответственно.

Чтобы увидеть свой файл robots.txt, нужно перейти по адресу Вашдомен.ru/robots.txt. Здесь будет отображаться все, что было прописано. Бывает так, что появляется ошибка 404. Это говорит о том, что было выполнено что-то не так при загрузке своего файла.

Запрет индексации ресурса при помощи панели инструментов

Способ закрытия сайта от индексации с помощью панели инструментов подойдет только для тех ресурсов, которые были сделаны на Вордпресс.

Порядок действий простой и быстрый:

Выполнение данных действий – всего лишь рекомендация для поисковых машин. А то, будут ли индексироваться или не индексироваться материалы ресурса, они решают самостоятельно. В настройках видимости сайта даже присутствует специальная строка: «Поисковые машины сами решают, следовать ли Вашей просьбе». Отметим, что Яндекс обычно «слушается», а Гугл может поступать по своему усмотрению и все равно в некоторых случаях индексировать сайт, несмотря на рекомендацию.

Закрытие сайта от индексации вручную

В исходном коде при закрытии страницы или всего ресурса от индексации появляется строка

Именно эта строка подсказывает поисковым машинам, что не нужно индексировать отдельные материалы или ресурс. Можно вручную в любом месте сайта прописать данную строчку. Главное, чтобы она отображалась на всех страницах.

Этот способ подойдет также для того, чтобы закрыть какой-либо ненужный документ от индексации.

После выполнения обновлений нужно проверить, все ли получилось. Для этого нужно открыть исходный код с помощью клавиш CTRL + U и посмотреть, есть ли в нем нужная строчка. Ее наличие подтверждает успешную операцию по закрытию от индексации. Дополнительно можно осуществить проверку в Яндекс Вебмастер и Google Webmaster.

Итак, мы рассмотрели самые простые и быстрые способы, позволяющие закрыть весь сайт или отдельные материалы ресурса от индексации поисковыми машинами. И, как выяснилось, robots.txt – один из легких и относительно надежных способов.

Проверка индексации сайта онлайн

Методы ускорения индексации сайта в яндексе

Директивы в файле robots.txt

Как использовать robots.txt и кеш Гугла

Быстрая индексация сайта в Гугле

Seo – проверка индексации текста и веса ссылок тест

Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

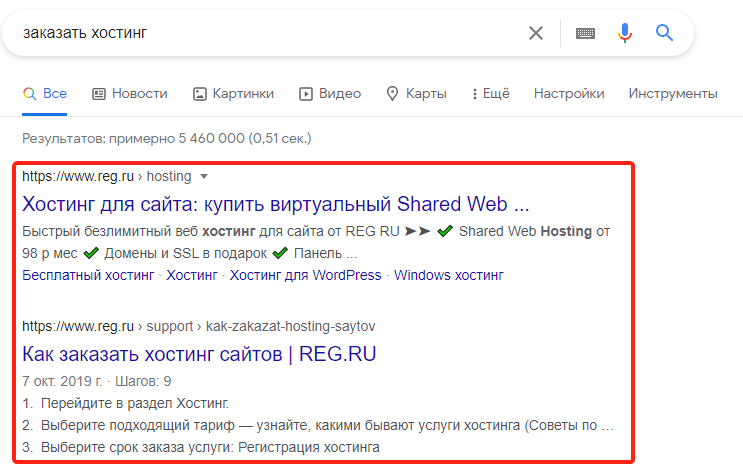

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

Добавьте в начало нужные строки.

Как закрыть сайт от индексации в robots.txt

Есть тысяча и одна причина, почему необходимо отключить индексацию части или всех страниц вашего сайта. Составим подробную инструкцию: как это сделать и какие варианты настроек индексирования сайта доступны.

Итак, в то время как все ресурсы мира гонятся за вниманием поисковых роботов ради вхождения в ТОП, вы решили скрыться от индексирования. На самом деле для этого может быть масса объективных причин. Например, сайт в разработке или проводится редизайн интерфейса.

Обратите внимание: можно запретить индексирование сайта целиком или отдельных его блоков или страниц. Для этого на помощь приходит служебный файл robots.txt.

Когда закрывать сайт целиком, а когда — его отдельные части?

Маленькие сайты-визитки обычно не требуют сокрытия отдельных страниц. Если ресурс имеет большое количество служебной информации, делайте закрытый портал или закрывайте страницы и целые разделы.

Желательно запрещать индексацию так называемых мусорных страниц. Это старые новости, события и мероприятия в календаре. Если у вас интернет-магазин, проверьте, чтобы в поиске не оказались устаревшие акции, скидки и информация о товарах, снятых с продажи. На информационных сайтах закрывайте статьи с устаревшей информацией. Иначе ресурс будет восприниматься неактуальным. Чтобы не закрывать статьи и материалы, регулярно обновляйте данные в них.

Лучше скрыть также всплывающие окна и баннеры, скрипты, размещенные на сайте файлы, особенно если последние много весят. Это уменьшит время индексации в целом, что положительно воспринимается поиском, и снизит нагрузку на сервер.

Как узнать, закрыт ресурс или нет?

Чтобы точно знать, идет ли индексация robots txt, сначала проверьте: возможно, закрытие сайта или отдельных страниц уже осуществлено? В этом помогут сервисы поисковиков Яндекс.Вебмастер и Google Search Console. Они покажут, какие url вашего сайта индексируются. Если сайт не добавлен в сервисы поисковиков, можно использовать бесплатный инструмент «Определение возраста документа в Яндексе» от Пиксел Тулс.

Закрываем сайт и его части: пошаговая инструкция.

Как полностью закрыть сайт в роботс?

Приведем пример закрытия сайта для основных роботов. Все вместе они обозначаются значком *.

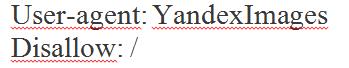

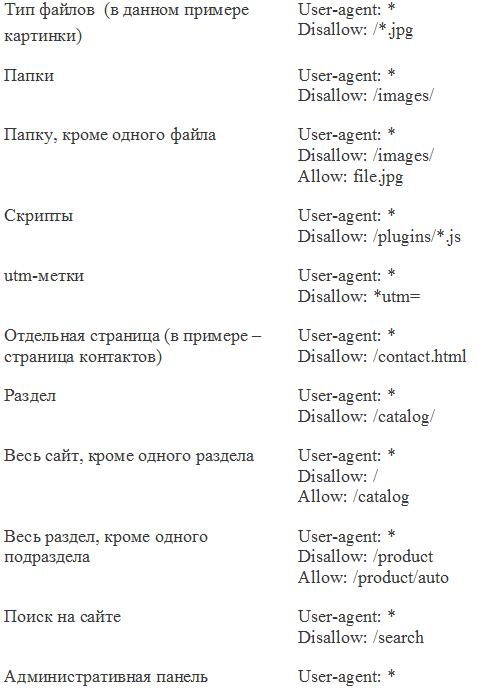

Файл robots.txt позволяет закрывать папки на сайте, файлы, скрипты, utm-метки. Их можно скрыть полностью или выборочно. При этом также указывайте запрет для индексации всем роботам или тем из них, кто ищет картинки, видео и т.п. Например, указание Яндексу не засылать к вам поиск картинок будет выглядеть как

Здесь YandexImages — название робота Яндекса, который ищет изображения. Полные списки роботов можно посмотреть в справке поисковых систем.

Как закрыть отдельные разделы/страницы или типы контента?

Выше мы показали, как запрещать основным или вспомогательным роботам заходить на сайт. Можно сделать немного по-другому: не искать имена роботов, отвечающих за поиск картинок, а запретить всем роботам искать на сайте определенный тип контента. В этом случае в директиве Disallow: / указываете либо тип файлов по модели *.расширениефайлов, либо относительный адрес страницы или раздела.

Прячем ненужные ссылки

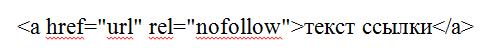

Иногда скрыть от индексирования нужно ссылку на странице. Для этого у вас есть два варианта.

Данный атрибут рекомендует роботу не принимать ссылку во внимание. В этом случае запрет индексации работает и тогда, когда поисковая система находит ссылку не через страницу, где переход закрыт в HTML-коде.

Как закрыть сайт через мета-теги

Существуют два варианта записи мета-тега.

Указывайте, для каких краулеров сайт закрыт от индексации. Если для всех, напишите robots. Если для одного робота, укажите его название: Googlebot, Яндекс.

Поле “content” из 1 варианта может иметь следующие значения:

Таким образом, можно запретить индексацию содержимого сайта независимо от файла robots.txt при помощи content=”noindex, follow”. Или разрешить ее частично: например, вы хотите не индексировать текст, а ссылки — пожалуйста. Используйте для разных случаев сочетания значений.

Если закрыть сайт от индексации через мета-теги, создавать robots.txt отдельно не нужно.

Какие встречаются ошибки

Логические ошибки означают, что правила противоречат друг другу. Выявляйте логические ошибки через проверку файла robots.txt в панелях инструментах Яндекс.Вебмастер и Google, прежде чем загрузить его на сайт..

Синтаксические — неправильно записаны правила в файле.

SEO Маяк

Блог Виталия Кириллова | Все о создании,

продвижении сайтов и заработке в интернете

Создание и продвижение сайтов, заработок в интернете

Файл robots.txt — запрет индексации для Яндекса и Google. Создание правильного robots.txt для WordPress

Здравствуйте уважаемые читатель SEO-Mayak.com! Сегодня я коснусь такой немаловажной темы, как «Индексация сайта поисковыми роботами». Вернее, речь пойдет как раз о запрете для индексации файлов не относящихся к контенту.

Зачем запрещать индексацию? Отвечая на этот вопрос я сразу оговорюсь, не надо запрещать поисковикам индексировать блог, необходимо наоборот всячески этому способствовать. Закрывать от индексации нужно только те файлы, которые не содержат полезную информацию. К таким относятся: системные файлы WordPress, а также дубли контента и некоторые другие файлы.

Наша задача правильно указать дорогу поисковым роботам к действительно важным файлам и «опустить шлагбаум» на пути к всякому «мусору». Для этого в арсенале у вебмастеров есть два незаменимых инструмента. С их помощью можно правильно организовать движение поисковиков по блогу, расставить «дорожные знаки» и приоритеты.

Первый инструмент — это файл robots.txt, который как раз и служит неким «регулировщиком», разрешающим роботам идти в одно место и запрещающего им идти в другое. Об этом файле и пойдет речь дальше.

Второй инструмент — это файл Sitemap.xml, который создает «дорожную разметку» (карту сайта) и значительно упрощает поисковикам навигацию по блогу. (Файл sitemap.xml для поисковиков Google и Яндекс)

Почему надо обязательно создавать файл robots.txt

Допустим, забрел поисковый робот на сайт или блог не важно, на котором по вине администратора или другого лица не был создан файл robots.txt. Что делает робот в первую очередь? В первую очередь он как раз ищет файл robots.txt, но так как такого файла нет, робот принимается знакомится с сайтом руководствуясь своими собственными секретными алгоритмами.

Вместо того, чтобы индексировать опубликованный материл, робот гуляет по каталогу wp-admin или wp-includes в поисках что-то похожего на контент. А через некоторое фиксированное время «Центр Управления» дает команду роботу следовать на сайт к Василию Пупкину и робот, так и не добравшись до главной цели своего визита — контента, отправиться гулять дальше по просторам интернета.

Но когда он вернется, а вернется он теперь нескоро, повториться вновь та же самая история, а горе-администратор будет греть себе голову, почему его сайт плохо индексируется.

Из этого всего можно сделать несколько полезных выводов:

Вывод №1. Время, отводящееся поисковой машине для индексации ресурса строго лимитировано.

Вывод №2. Робот наверняка сообщит в своем рапорте «Центру Управления» о сайте в котором нечего индексировать и ЦУ поправит расписание следующего посещения с пометкой — «Посещать реже».

Вывод№3. При многократном повторении такой ситуации ЦУ обязательно примет меры по ниспровержению позиций такого не благонадежного ресурса и задвинет в глубь поиска от греха по-дальше.

Так вот, чтобы не ощущать себя в роли «горе администратора» надо обязательно создать файл robots.txt и правильно расставить в нем «запрещающие знаки», тем самым указывать самую короткую дорогу до контента, который действительно необходимо индексировать.

Создаем правильный robots.txt для WordPress

Новичкам наверное сложно понять процесс создания файла robots.txt, хотя в принципе сильно хитрого ничего нет. Постараюсь разложить все по полочкам.

Файл robots.txt должен находиться в корне сайта. Как закачивать файлы на сервер читайте в статье — «FTP клиент Filezilla»

создается с помощью обычного текстового документа имеющего формат .txt в котором прописываются следующий директивы:

Директива — «User-agent:»

Директива «User-agent» служит для указания названия поискового робота, например:

Все директивы, которые расположены ниже будут относится непосредственно к роботу Яндекса.

В этом случаю дальнейшие директивы будут обращены к Гуглу.

Можно написать и так:

Наверное вам будет интересно узнать названия роботов остальных известных поисковых систем, список ниже:

Надо отметить, что каждый крупный поисковик имеет команду роботов «помощников» и все они имеют свое индивидуальное предназначение. На буду перебирать все поисковики, остановлюсь лишь на роботах Яндекса:

Для всех перечисленных роботов можно задавать отдельные директивы.

Директива — «Disallow:»

Директива «Disallow:» запрещает роботу индексировать указанную часть сайта или весь сайт целиком, смотря какое значение содержит данная директива. Например:

Директива «Disallow:» содержит спецсимвол «/», который является запрещающим знаком, а так как после него ни чего не указано, робот понимает это, как команду запрещающую индексацию всего сайта в целом.

Если после спецсимвола «/» прописать название какого-нибудь каталога, например:

Для робота это будет означать запрет индексации всего, что находиться в каталоге wp-admin. Не трудно догадаться, что таким способом можно блокировать путь робота к каталогам или отдельным файлам, а также пути в URL адресе. Например, этот URL будет блокирован:

Но как же быть если надо разрешить роботу зайти в определенный каталог и уже потом запретить ему дальнейшее продвижение по некоторым направлениям? Делается это просто:

Как Вы уже догадались, прописывается путь до каталога, который надо блокировать.

Также можно запретить индексацию по символам таких, как «?», встречающимся в URL ведущем на определенные страницы:

Давайте разберемся в последней директиве, что там за знаки такие. Как я уже писал выше, спецсимвол «*» обозначает любой текст — значит запрещаются любые URL, которые включают в себя символ «?», причем этот символ должен находиться между любыми другими символами. Пример:

Если в некоторых «нежелательных» URL символ «?» находиться в конце, то прописывать надо так:

Надеюсь, объяснил понятно.

Теперь наверное у многих может возникнуть вопрос — «А зачем запрещать роботу индексировать URL, ведь это и есть контент?»

Дело в том, что один и тот же контент очень часто бывает доступен по разным URL и это приводит к его дублированию в рамках одного сайта. Дубли бывают полными или частичными (под частичными дублями подразумеваются анонсы записей) Поисковые системы негативно относятся к таким проявления и если дубликатов много, то в худшем случаи сайт может загреметь под фильтр.

Поэтому просканируйте Ваш сайт на дубликаты и запретите их индексацию в файле robots.txt с помощью символов входящих в URL. Про дубли страниц читайте в статье — «Похожие, дублированные страницы. Как выявить дубли контента«.

В данном примере спец символ «$» указал на запрет индексации URL содержащего в себе последовательность букв «page» но не запретил индексировать page.php,что позволяет белее тонко производить настройку файла robots.txt.

Директива — «Allow:»

Если директива «Disallow:» являются запрещающей, то «Allow:» — разрешающей. К ней можно прописывать те же значения как и к «Disallow:»

Директива — «Host:»

Директива — «Sitemap:»

Директива «Sitemap:» указывает путь ко второму незаменимому инструменту, ускоряющему индексацию — это файлы sitemap.xml и файл sitemap.xml.gz создающие карту сайта для поисковиков. Пример:

Я прошелся по основным директивам, которые применяются при создании файла robots.txt, но хочу дать еще один совет. Файл robots.txt доступен для просмотра любому пользователю интернета достаточно набрать в адресной строке сайт.ru/robots.txt и Вы сможете посмотреть robots.txt у любого сайта, кстати мой блог не исключение.

В заключении хочу сказать, что за процессом индексации надо поглядывать и в случаи необходимости вносить изменения в файл robots.txt.

Проверить файл robots.txt можно можно по следующим адресам:

Яндекс вебмастер — анализ robots.txt

1. Вписываете URL блога без http:// и без https://

2. Нажимаете кнопку — «Загрузить robots.txt с сайта».

3. После того как файл загрузиться нажимаете кнопку — «Проверить».

Google Инструменты для вебмастеров — Заблокированные URL

Если имеются вопросы, готов выслушать. Высказывайтесь пожалуйста в комментариях.

Читайте также, как создать динамическую XML карту сайта.

С уважением, Кириллов Виталий